Công nghệ mới đang thách thức giới hạn của các chất bán dẫn máy tính. Để giải quyết vấn đề này, các nhà nghiên cứu đã tìm kiếm các ý tưởng từ tự nhiên.

Ngày nay chúng ta mong đợi rất nhiều từ những chiếc máy tính: có thể trò chuyện với chúng ta, nhận diện mọi thứ từ khuôn mặt đến hoa lá, và chẳng lâu nữa là tự lái xe. Toàn bộ trí tuệ nhân tạo này đòi hỏi một lượng khổng lồ các phép toán, thách thức giới hạn của cả những máy móc hiện đại nhất.

Nhằm đáp ứng những yêu cầu ngày càng tăng, một số công ty công nghệ lớn nhất thế giới hiện đang tìm kiếm ý tưởng từ ngành sinh học. Các hãng này xem xét lại bản chất của các máy tính và tạo ra các máy móc, thiết bị giống với não bộ của con người. Cụ thể sẽ gồm thân não trung ương điều khiển hệ thống thần kinh và ra lệnh thực hiện các hành động cụ thể như nghe, nhìn tới vỏ não xung quanh.

Sau hàng năm trời trì trệ, máy tính đang phát triển trở lại và sự chuyển hướng âm thầm sang một loại thiết bị mới sẽ có ý nghĩa lớn rộng và lâu dài. Điều này sẽ thúc đẩy mảng trí thông minh nhân tạo phát triển. Do đó, mơ ước về các thiết bị có thể tự điều khiển hoặc hoạt động có thể trở thành hiện thực một ngày không xa.

Sự chuyển dịch này có thể làm giảm sức mạnh của Intel – gã khổng lồ lâu năm trong thiết kế và sản xuất chip, đồng thời cũng tái tạo ngành công nghiệp bán dẫn trị giá 335 tỷ USD/năm. Ngành này đang nắm giữ vị trí trung tâm về công nghệ, từ trung tâm dữ liệu điều hướng Internet, chiếc điện thoại iPhone đến những chiếc tai nghe thực tế ảo và máy bay không người lái trong tương lai.

John Hennessy, nguyên hiệu trưởng Đại học Stanford, người đã viết cuốn sách chuyên sâu về thiết kế máy tính vào giữa những năm 1990 và hiện là thành viên hội đồng quản trị tại Alphabet (công ty mẹ của Google), cho biết: “Đây là một sự thay đổi to lớn. Cách tiếp cận hiện tại sắp ‘hết thời’, và mọi người đang cố gắng tái thiết kế hệ thống“.

Xuedong Huang (bên trái) và Doug Burger của Microsoft là những nhân viên đứng đầu các dự án phát triển chip chuyên dụng của hãng. Ảnh: The New York Times

Cách tiếp cận hiện tại tạo ra một cuộc chạy đua khá thú vị. Trong khoảng nửa thế kỷ, các nhà sản xuất máy tính đã xây dựng các hệ thống chỉ với một con chip đảm nhiệm tất cả, đóng vai trò đơn vị xử lý trung tâm. Các con chip này được tạo ra bởi các công ty như Intel – một trong những nhà sản xuất bán dẫn lớn nhất thế giới. Bạn có thể tìm thấy các con chip này trong laptop hoặc smartphone của mình.

Hiện tại, các kỹ sư máy tính đang xây dựng những hệ thống phức tạp hơn. Thay vì tập trung toàn bộ tác vụ vào một con chip mạnh mẽ của Intel, các thiết bị mới chia công việc thành các phần nhỏ xíu và phân chia tới các con chip đơn giản, chuyên dụng và tiêu tốn ít năng lượng hơn.

Những thay đổi bên trong các trung tâm dữ liệu khổng lồ của Google là dấu hiệu mở đầu những diễn biến sắp tới trong lĩnh vực này. Trong hầu hết các máy chủ của Google vẫn là một bộ xử lý trung tâm, tuy nhiên cùng hoạt động với nó là cả một “kho” chip tùy chỉnh chạy các thuật toán máy tính để thực hiện nhận dạng giọng nói và các hình thức trí tuệ nhân tạo khác.

Google bất đắc dĩ thực hiện điều này. Trong nhiều năm, hãng đã điều hành mạng máy tính lớn nhất thế giới – một đế chế các trung tâm dữ liệu và dây cáp trải dài từ California tới Phần Lan, Singapore. Tuy nhiên, đối với một chuyên gia nghiên cứu của Google, nó vẫn là quá nhỏ.

Năm 2011, Jeff Dean, một trong những kỹ sư nổi tiếng nhất của Google đã dẫn đầu một nhóm nghiên cứu ý tưởng về mạng thần kinh nhân tạo – chủ yếu là các thuật toán máy tính có thể tự học các nhiệm vụ. Các nhiệm vụ này có thể hữu ích cho một số việc như nhận dạng giọng nói đối với thiết bị smartphone hoặc nhận diện khuôn mặt trong một bức ảnh.

Trong vài tháng, Dean và nhóm của mình đã xây dựng một dịch vụ có thể nhận diện lời nói chính xác hơn nhiều so với dịch vụ hiện tại của Google. Tuy nhiên, chuyên gia nhận ra vấn đề: Nếu hơn một tỷ chiếc điện thoại Android trên thế giới sử dụng dịch vụ mới chỉ khoảng ba phút mỗi ngày thì Google sẽ phải tăng gấp đôi dung lượng trung tâm dữ liệu để phục vụ.

Trong một cuộc họp, Dean đã nói với chuyên gia máy tính Urs Hölzle – người giám sát trung tâm dữ liệu của công ty: “Chúng ta cần một Google khác“. Dean đề xuất một giải pháp thay thế: Google có thể tự làm ra con chip máy tính riêng cho mình chỉ để phục vụ cho trí thông minh nhân tạo.

Tuy nhiên những gì diễn ra bên trong các trung tâm dữ liệu đang thay đổi các phần khác của bức tranh toàn cảnh về công nghệ. Trong vài năm tới, các công ty như Google, Apple và Samsung sẽ tạo ra những chiếc điện thoại với các con chip AI chuyên dụng. Microsoft đang thiết kế một con chip như vậy dùng chuyên biệt cho thiết bị tai nghe thực tế ảo tăng cường. Và các hãng, từ Google đến Toyota, đều đang xây dựng những chiếc ô tô tự lái cần đến những con chip tương tự.

Theo Gill Pratt, nguyên Quản lý chương trình tại Darpa (bộ phận nghiên cứu của Bộ Ngoại giao, Bộ Quốc phòng Hoa Kỳ) và hiện đang làm về ô tô không người lái tại Toyota thì xu hướng sử dụng những con chip chuyên biệt và kiến trúc máy tính mới có thể dẫn tới sự “bùng nổ kỷ Cambri” của trí thông minh nhân tạo. Gill cho rằng, các máy móc thực hiện việc tính toán trên một số lượng lớn các chip nhỏ, ít năng lượng sẽ hoạt động giống não bộ con người hơn. Và điều này giúp sử dụng năng lượng hiệu quả.

“Trong não bộ, việc sử dụng năng lượng hiệu quả đóng vai trò then chốt“, Gill chia sẻ trong cuộc phỏng vấn gần đây tại trung tâm nghiên cứu mới của Toyota ở Thung lũng Silicon.

Thay đổi phương hướng

Có nhiều loại chip silicon: chip lưu trữ thông tin, chip thực hiện các tác vụ cơ bản trong đồ chơi, tivi và có những con chip chạy các quy trình khác nhau cho máy tính, từ các siêu máy tính được sử dụng để tạo ra các mô hình hâm nóng toàn cầu tới máy tính cá nhân, máy chủ Internet và smartphone.

Trong nhiều năm, các đơn vị xử lý trung tâm (CPU) chạy máy tính cá nhân và các thiết bị tương tự là nơi tập trung nguồn tiền và không có nhiều động lực cần phải thay đổi.

Theo Định luật Moore (xây dựng bởi đồng sáng lập Intel Gordon Moore), số lượng bóng bán dẫn (tranzitor) trên một chip máy tính cứ sau khoảng 2 năm lại tăng gấp đôi và hiệu suất được cải thiện dần qua các năm. Theo một định luật ít được biết đến hơn về thiết kế chip có tên gọi Dennard scaling (theo tên gọi của nhà nghiên cứu lâu năm của IBM Robert Dennard), nhờ được cải thiện nên các con chip tiêu thụ xấp xỉ cùng một lượng năng lượng.

Tuy nhiên, đến năm 2010 việc tăng gấp đôi số bóng bán dẫn đã mất nhiều thời gian hơn so với dự đoán của Định luật Moore. Định luật Dennard scaling cũng bị đảo lộn khi các nhà thiết kế chip vấp phải giới hạn của các vật liệu vật lý được sử dụng để tạo ra các bộ vi xử lý. Kết quả là: Nếu một công ty muốn có nhiều năng lượng tính toán hơn cũng không thể nâng cấp bộ vi xử lý của mình. Công ty đó cần nhiều máy tính hơn, nhiều không gian hơn và tiêu thụ nhiều điện hơn.

Các nhà nghiên cứu trong ngành và tại các học viện đã nỗ lực để mở rộng Định luật Moore, khám phá các nguyên liệu làm chip và kỹ thuật thiết kế hoàn toàn mới. Tuy nhiên Doug Burger, một nhà nghiên cứu tại Microsoft, có một ý tưởng khác: Thay vì phụ thuộc vào sự cải tiến chậm chạp của bộ xử lý trung tâm, như ngành này xưa nay vẫn vậy từ những năm 1960, tại sao không chuyển bớt tải (load) sang các chip chuyên dụng?

Trong kỳ nghỉ Giáng sinh năm 2010, Burger cùng một số nhà nghiên cứu chip khác của Microsoft đã bắt đầu nghiên cứu các phần cứng mới có thể đẩy nhanh hiệu suất của Bing – công cụ tìm kiếm Internet của hãng.

Tại thời điểm đó, Microsoft mới bắt đầu cải tiến Bing thông qua sử dụng các thuật toán học máy (các mạng nơ-ron là một dạng học máy) có thể cải thiện kết quả tìm kiếm bằng cách phân tích cách mọi người sử dụng dịch vụ. Mặc dù các thuật toán yêu cầu ít hơn so với các mạng nơ-ron mà sau này sẽ tái cơ cấu Internet, nhưng các chip hiện tại đã gặp khó khăn trong việc bắt kịp xu hướng đó.

Burger và nhóm nghiên cứu của mình đã thử nhiều phương án nhưng cuối cùng quyết định xây dựng Field Programmable Gate Arrays (F.P.G.A.): các con chip được lập trình lại để thực hiện các nhiệm vụ mới. Microsoft tạo ra phần mềm, tương tự như Windows, chạy trên C.P.U Intel. Tuy nhiên phần mềm như vậy không thể lập trình lại chip, bởi nó đã được fix cứng để thực hiện một số nhiệm vụ nhất định.

Với một F.P.G.A, Microsoft có thể thay đổi cách thức hoạt động của chip. Hãng có thể lập trình chip thực sự tốt cho việc thực hiện các thuật toán học máy cụ thể. Sau đó, các chip này lại được tái lập trình để chạy logic thật tốt, gửi hàng triệu các gói dữ liệu qua mạng máy tính. Đó là cùng một chip nhưng hoạt động theo một cách khác.

Microsoft bắt đầu sử dụng các con chip như vậy vào năm 2015. Hiện tại, cứ mỗi máy chủ mới được nạp vào trung tâm dữ liệu của Microsoft đều bao gồm một trong những con chip có thể lập trình này. Chúng giúp chọn các kết quả khi người dùng tìm kiếm trên Bing và giúp Azure (dịch vụ điện toán đám mây của Microsoft) truyền tải thông tin qua mạng lưới các máy cơ bản.

Dạy máy tính cách “nghe”

Vào mùa thu năm 2016, một nhóm nghiên cứu khác của Microsoft đã làm công việc tương tự của Jeff Dean tại Google. Các chuyên gia này đã xây dựng một mạng lưới thần kinh nhân tạo mà bằng ít nhất một biện pháp có thể nhận dạng giọng nói chính xác hơn mức trung bình của con người.

Chuyên gia về nhận dạng giọng nói Xuedong Huang (sinh ra tại Trung Quốc) đã dẫn đầu nỗ lực này. Một thời gian ngắn sau khi nhóm nghiên cứu này đưa ra bài báo mô tả công việc của mình, Huang đã có buổi ăn tối trên những ngọn đồi phía trên Palo Alto, Calif cùng với người bạn cũ Jen-Hsun Huang – Giám đốc điều hành của nhà sản xuất chip Nvidia. Hai người đàn ông có lý do để ăn mừng, và họ chúc nhau một chai sâm-panh.

Jeff Dean, một trong những kỹ sư nổi tiếng nhất của Google, cho biết công ty nên phát triển một con chip để chạy trí thông minh nhân tạo. (Ảnh: Ryan Young, New York Times)

Xuedong Huang và các cộng sự Microsoft đã xây dựng dịch vụ nhận dạng giọng nói bằng cách sử dụng một số lượng lớn các chip chuyên dụng do Nvidia cung cấp, thay vì chủ yếu dựa vào các chip Intel thông thường. Nếu họ không thay đổi thì đã không thể có bước đột phá.

“Chúng tôi đã thu ngắn khoảng cách giữa máy móc với con người trong khoảng một năm. Nếu chúng tôi không có vũ khí là cơ sở hạ tầng, thì phải mất ít nhất 5 năm“, Huang cho biết.

Các hệ thống dựa vào mạng nơ-ron nhân tạo có thể tự học là chính nên có thể phát triển nhanh hơn các dịch vụ truyền thống. Các hệ thống này không phụ thuộc vào việc các kỹ sư viết những dòng code dài vô tận giải thích cách chúng phải làm những việc gì.

Nhưng có một vấn đề nhỏ: Việc đào tạo mạng nơ-ron nhân tạo theo cách này đòi hỏi phải kiểm thử nhiều. Để tạo ra một sản phẩm có khả năng nhận dạng từ ngữ như con người, các nhà nghiên cứu phải đào tạo nhiều lần, tinh chỉnh các thuật toán và cải tiến đi cải tiến lại dữ liệu. Vào bất kỳ thời điểm nào, quá trình này sẽ mở ra hàng trăm thuật toán. Điều đó đòi hỏi sức mạnh tính toán khổng lồ và nếu các công ty như Microsoft sử dụng các chip thông thường để làm điều đó thì quá trình này mất quá nhiều thời gian vì các chip không thể xử lý tải và cần tiêu tốn quá nhiều năng lượng điện.

Vì vậy, các công ty Internet hàng đầu đang “đào tạo” mạng nơ-ron nhân tạo của mình với sự hỗ trợ của một loại chip khác được gọi là bộ xử lý đồ hoạ, hoặc G.P.U. Các chip năng lượng thấp này (thường do Nvidia sản xuất) ban đầu được thiết kế để xuất (render) các hình ảnh cho các trò chơi và phần mềm khác, và chúng “hợp tác” chặt chẽ với chip (thường do Intel sản xuất) tại trung tâm máy tính. Các G.P.U có thể xử lý toán học được các mạng nơ-ron yêu cầu một cách hiệu quả hơn nhiều so với các C.P.U.

Kết quả là, Nvidia đang phát triển mạnh và hiện đang bán số lượng lớn các G.P.U cho các gã khổng lồ Internet của Mỹ và các công ty trực tuyến lớn nhất trên thế giới, đặc biệt là ở Trung Quốc. Theo thống kê của Trung tâm dữ liệu, doanh thu hàng quý của Nvidia tăng gấp ba lần, lên tới 409 triệu đô la trong năm qua.

Jen-Hsun Huang trong một cuộc phỏng vấn gần đây cho biết: “Điều này tương đối giống với giai đoạn khởi đầu của Internet“. Nói cách khác, bối cảnh công nghệ đang thay đổi nhanh chóng và Nvidia là trọng tâm của sự thay đổi đó.

Chế tạo các con chip chuyên dụng

G.P.U là những phương tiện cơ bản mà các công ty sử dụng để “dạy” một nhiệm vụ cụ thể cho các mạng nơ-ron nhân tạo. Tuy nhiên, đó chỉ là một phần của tiến trình. Sau khi mạng thần kinh nhân tạo được dạy một tác vụ, nó phải thực hiện tác vụ đó và cần đến một dạng sức mạnh tính toán khác.

Ví dụ, sau khi dạy một thuật toán nhận dạng giọng nói, Microsoft đưa vào sử dụng như một dịch vụ trực tuyến và bắt đầu xác định các lệnh mà người dùng ra lệnh trên điện thoại thông minh của mình. Các G.P.U. không hoàn toàn hiệu quả trong cả giai đoạn này của tiến trình. Do đó, nhiều công ty đang xây dựng các chip chuyên dụng để làm những gì các chip khác đã “học” được.

Google đã tự chế tạo chip chuyên dụng cho mình có tên Tensor Processing Unit (đơn vị xử lý độ trễ) hay T.P.U. Nvidia cũng đang xây dựng một con chip tương tự. Và Microsoft đã tái lập trình các con chip chuyên dụng từ Altera (được Intel mua lại) do đó có thể chạy mạng thần kinh nhân tạo dễ dàng hơn.

Các công ty khác cũng đang theo sát. Qualcomm (chuyên về chip cho smartphone) và một số doanh nghiệp start-up cũng đang nghiên cứu về chip AI, hy vọng chiếm được một phần của thị trường đang phát triển nhanh chóng này. Công ty nghiên cứu công nghệ IDC dự đoán rằng doanh thu từ các máy chủ được trang bị chip thay thế sẽ đạt 6,8 tỷ USD vào năm 2021, khoảng 10% toàn bộ thị trường máy chủ.

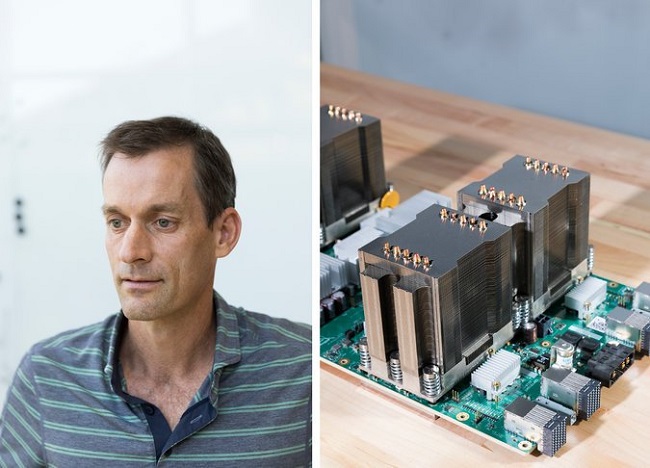

Bart Sano – Phó chủ tịch phụ trách Kỹ thuật, người đứng đầu mảng phát triển phần cứng và phần mềm cho mạng của Google, thừa nhận rằng các chip chuyên dụng vẫn là một phần khá khiêm tốn trong hoạt động của công ty. Ảnh: Ryan Young, The New York Times

Trên mạng máy tính của Microsoft, Burger chỉ ra rằng các chip thay thế vẫn là một phần khá khiêm tốn trong hoạt động. Bart Sano – Phó chủ tịch phụ trách Kỹ thuật, người đứng đầu mảng phát triển phần cứng và phần mềm cho mạng của Google cho biết, gần giống như các chip được triển khai tại các trung tâm dữ liệu của họ.

Lãnh đạo Intel Labs – Mike Mayberry hạn chế việc chuyển đổi sang các bộ xử lý thay thế, có lẽ bởi Intel kiểm soát hơn 90% thị trường trung tâm dữ liệu và là nhà bán chip truyền thống lớn nhất. Mike cho biết nếu các bộ xử lý trung tâm được điều chỉnh đúng cách thì cũng có thể xử lý các tác vụ mới mà không cần thêm sự trợ giúp nào.

Nhưng loại silicon mới này đang nhanh chóng trở nên phổ biến và Intel đang ngày càng mâu thuẫn với chính mình. Đó là Intel từ chối rằng thị trường đang thay đổi nhưng cũng chuyển hướng kinh doanh để theo kịp với sự thay đổi đó.

Hai năm trước, Intel đã chi 16,7 tỷ USD để mua lại Altera – hãng sản xuất các chip lập trình mà Microsoft sử dụng. Đây là thương vụ mua lại lớn nhất của Intel. Năm ngoái, hãng này đã chi 408 triệu USD để mua Nervana, công ty đang phát triển chip chuyên về mạng nơ-ron thần kinh nhân tạo. Hiện tại, với sự dẫn dắt của Nervana, Intel đang phát triển một con chip chuyên dụng để “dạy” và điều khiển mạng nơ ron thần kinh nhân tạo.

Bill Coughran, một đối tác của công ty đầu tư mạo hiểm Sequoia Capital tại Thung lũng Silicon, người đã dành gần một thập kỷ để giám sát cơ sở hạ tầng trực tuyến của Google, nhắc đến Intel: “Họ có vấn đề của một công ty lớn truyền thống. Họ cần phải tìm ra cách chuyển dịch vào các lĩnh vực mới đang phát triển mà không làm ảnh hưởng đến việc kinh doanh truyền thống của mình“.

Xung đột bên trong của Intel là rõ ràng nhất khi các quan chức hãng này thảo luận về sự yếu đi của Định luật Moore. Trong cuộc phỏng vấn gần đây với The New York Times, Naveen Rao, người sáng lập Nervana và hiện là giám đốc điều hành của Intel, cho biết Intel có thể co kéo “thêm vài năm nữa” ra ngoài Định luật Moore. Định vị của hãng này chính là những cải tiến trong các chip truyền thống sẽ tiếp tục tốt lên trong thập kỷ tiếp theo.

Mayberry của Intel lập luận rằng việc sử dụng thêm chip không phải là mới. Trong quá khứ, các nhà sản xuất máy tính đã sử dụng các chip riêng cho các tác vụ như xử lý âm thanh.

Tuy nhiên hiện tại phạm vi xu hướng mở rộng hơn nhiều. Và điều này đang thay đổi thị trường theo những cách mới. Intel đang cạnh tranh không chỉ với các nhà sản xuất chip như Nvidia và Qualcomm, mà còn với các công ty như Google và Microsoft.

Google đang thiết kế thế hệ thứ hai cho chip T.P.U. Hãng cho biết, cuối năm nay các doanh nghiệp, nhà phát triển là khách hàng dịch vụ điện toán đám mây của Google có thể sử dụng các chip mới để chạy phần mềm của mình.

Trong khi sự thay đổi này diễn ra chủ yếu bên trong các trung tâm dữ liệu khổng lồ nền tảng Internet, thì việc nó lan rộng vào ngành công nghiệp có lẽ chỉ là vấn đề thời gian.

Hy vọng là con chip di động mới này có thể giúp các thiết bị tự xử lý nhiều với các tác vụ phức tạp hơn mà không cần phải “xin lệnh” từ các trung tâm dữ liệu ở xa: các điện thoại nhận lệnh giọng nói mà không cần truy cập Internet; những chiếc xe không người lái nhận ra môi trường xung quanh nhanh và chính xác – những điều mà hiện tại là chưa thể.

Nói cách khác, một chiếc xe không người lái cần máy ảnh, radar và laser. Nhưng nó cũng cần một bộ não.

Hà Loan

Theo NYTimes

Nguồn: http://vnreview.vn/tin-tuc-xa-hoi-so/-/view_content/content/2342494/nganh-ban-dan-dang-chuyen-huong-phat-trien-chip-dua-tren-cau-truc-nao-nguoi